NVIDIA TensorRT, yapay zeka hızlandırma alanında devrim yaratan bir teknoloji olarak dikkat çekiyor. Bu yenilikçi çözüm, GeForce RTX GPU’lar için optimize edilmiş performans sunarak, kullanıcılarının yapay zeka uygulamalarında 2 kat daha hızlı sonuçlar elde etmesine olanak tanıyor. NVIDIA’nın TensorRT’si, DirectML ile karşılaştırıldığında %200’e kadar performans artışı sağlarken, Windows ML ile de entegre çalışarak sorunsuz bir kullanıcı deneyimi sunuyor. Tekrar incelemek gerekirse, otomatik olarak optimize edilmiş çıkarımlar sayesinde geliştiriciler, projelerinde daha düşük donanım gereksinimleri ile yüksek performans alabilme avantajına sahip. Ayrıca, ONNX Runtime ile uyumlu çalışan TensorRT, özellikle yapay zeka uygulamalarında hız ve verimliliği artırarak geliştirici topluluğunun iş akışlarını tamamen dönüştürüyor.

NVIDIA’nın son teknolojisi, RTX platform için özel olarak geliştirilmiş yapay zeka hızlandırma çözümleri sunarak dikkatleri üzerine çekiyor. Bu yeni nesil altyapı, GPU’lar üzerinden yapılan çıkarmalarda DirectML’e göre önemli bir üstünlük sağlıyor, bu da kullanıcıların daha hızlı ve verimli yapay zeka uygulamaları geliştirmesine yardımcı oluyor. Yeni Windows ML, uygulamaların çeşitli donanım yapılandırmalarında en iyi performansı elde etmesini sağlarken, ayrıca mikro hizmetler ve AI script yazımlarının entegrasyonuna destek veriyor. Bu çerçevede, NVIDIA TensorRT, geliştiricilere ve kullanıcılarına gerçekleştirdikleri çalışmaların kalitesini artırma adına sağladığı kolaylıklarla, AI ekosisteminde önemli bir yer ediniyor. Dikkat çeken bir diğer unsur da, TensorRT’nin mevcut SDK’lar arasında sunduğu uyumluluk ve hızlandırma özellikleri sayesinde, geliştirme süreçlerinin daha hızlı ve kolay bir hale gelmesi.

NVIDIA TensorRT Nedir?

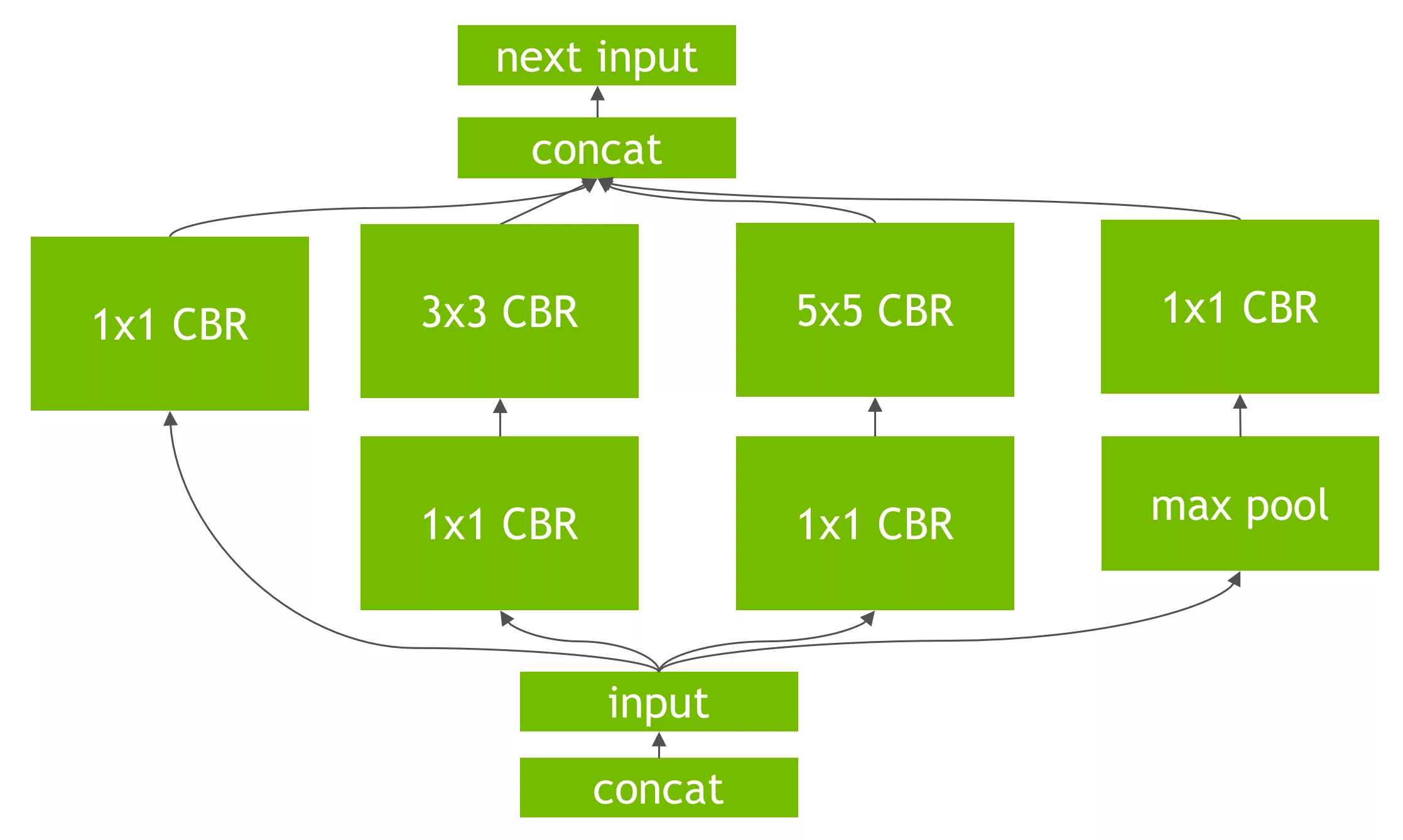

NVIDIA TensorRT, derin öğrenme modellerinin optimizasyonu için geliştirilmiş yüksek performanslı bir kütüphanedir. Kullanıcıların, eğitilen modellerini daha hızlı hale getirerek, yapay zeka uygulamalarının verimliliğini artırmalarına yardımcı olur. Özellikle, real-time inference uygulamalarında büyük avantajlar sunarak, düşük gecikme süreleri ve yüksek throughput (işlem hızı) sağlamak için tasarlanmıştır. TensorRT, karmaşık yapay zeka modellerini daha etkin bir şekilde çalıştırmak için birçok optimizasyon tekniği kullanır. Bu teknikler arasında, ağırlık sıkıştırma, düzeltme ve fp16 (float16) ile çalışabilme yeteneği bulunur.

TensorRT, kullanıcıların mevcut modellerini analiz edip, en uygun performansı elde etmek için otomatik olarak optimize edebildiği bir yapıya sahiptir. Örneğin, bir CNN (Convolutional Neural Network) modelini ele alırsak, TensorRT bu modeli daha küçük boyutlu ve daha hızlı çalışacak şekilde yeniden yapılandırabilir. Bu durum, aynı zamanda enerji verimliliği sağlarken, donanım üzerinde gereksiz yüklenmeyi de azaltabilir. Sonuç olarak, kullanıcılar, daha az kaynak harcayarak daha fazla işlem yapma olanağına sahip olurlar.

TensorRT ile Performans Artışı

NVIDIA TensorRT’nin en dikkat çekici özelliklerinden biri, AI performansını iki katına çıkarabilme yeteneğidir. Yapılan araştırmalara göre, doğru yapılandırılmış bir TensorRT uygulaması, standart bir derin öğrenme modeline göre inference sürelerini %40 ila %80 oranında azaltabilir. Bu durum, hem daha hızlı sonuçlar almak hem de daha kısa sürede daha fazla kullanıcıya hizmet sunmak için kritik bir avantajdır. Örneğin, bir görüntü tanıma uygulamasında, TensorRT ile optimize edilmiş bir model, geleneksel bir modelden daha kısa sürede daha fazla resmi işleyebilir, bu da işletmelere büyük ölçüde zaman kazandırır.

Ayrıca, TensorRT, GPU’ların tam potansiyelini kullanarak işlem gerçekleştiren uygulamalar için özellikle değerlidir. Geliştiriciler, TensorRT’yi kullanarak, modelin API’lerini GPU’lar üzerinde etkili bir şekilde çalışacak şekilde ince ayarlama yapabilirler. Örneğin, NVIDIA, TensorRT kullanan bir derin öğrenme modelinin, TensorFlow veya PyTorch gibi popüler çerçevelerle birleştirildiğinde %2 katından fazla bir performans artışı sağlayabileceğini bildirmiştir. Bu nedenle, TensorRT, hem önceden eğitilmiş modeller hem de yeni geliştirilen projelerde, performans iyileştirmenin vazgeçilmez bir aracı haline gelmiştir.

Ticari Uygulamalardaki Yeri

NVIDIA TensorRT, ticari uygulamalar üzerinde ciddi bir etki sağlamakta ve birçok sektörde kullanılmaktadır. Sağlık hizmetleri, otomotiv, güvenlik ve finans alanları gibi farklı sektördeki şirketler, yoğun iş yüklerini yönetme ve hızlı karar verme süreçlerini optimize etme amacıyla TensorRT’den faydalanmaktadır. Örneğin, sağlık sektöründe, birçok hastane, hastaların görüntülerini anlık olarak analiz edebilmek için TensorRT’yi kullanarak hastalık teşhis süreçlerini hızlandırmakta ve bu sayede acil durumlarda daha etkili müdahale edebilmektedir.

Otomotiv sektöründe ise, otonom araçlar için anlık karar alma mekanizmaları oluşturmak için TensorRT’den yararlanılmaktadır. Otonom sürüş simülasyonlarında, hızla işlenen veriler sayesinde araçlar daha güvenli bir şekilde navigasyon yapabilir, engelleri tespit edebilir ve karmaşık trafik durumlarına tepki verebilir. Bu tür uygulamalar, yapay sapmalara karşı daha dayanıklı hale gelmesini sağlayarak, sonuçta hem güvenliği hem de verimliliği artırmaktadır. Böylece, TensorRT’nin sağladığı performans iyileştirmeleri, sadece yazılım geliştirme sürecini etkilemekle kalmıyor, aynı zamanda ürün ve hizmetlerin kalitesini de artırıyor.

TensorRT’nin Avantajları ve Optimizasyon Süreci

TensorRT’nin sağladığı avantajlar sadece hızla sınırlı değildir; aynı zamanda kullanıcılara maliyet tasarrufu da sunmaktadır. Yapay zeka modellerinin daha az enerji harcayarak çalışması, veri merkezi işletim maliyetlerini önemli ölçüde azaltabilir. Örneğin, yapılan bir araştırmada, TensorRT kullanılan sistemlerin enerji verimliliği, diğer sistemlere göre %30 oranında daha iyi sonuçlar vermektedir. Bu bağlamda, hem çevresel etkilerin azaltılması hem de maliyetlerin daha yönetilebilir hale gelmesi için TensorRT büyük bir fırsat sunmaktadır.

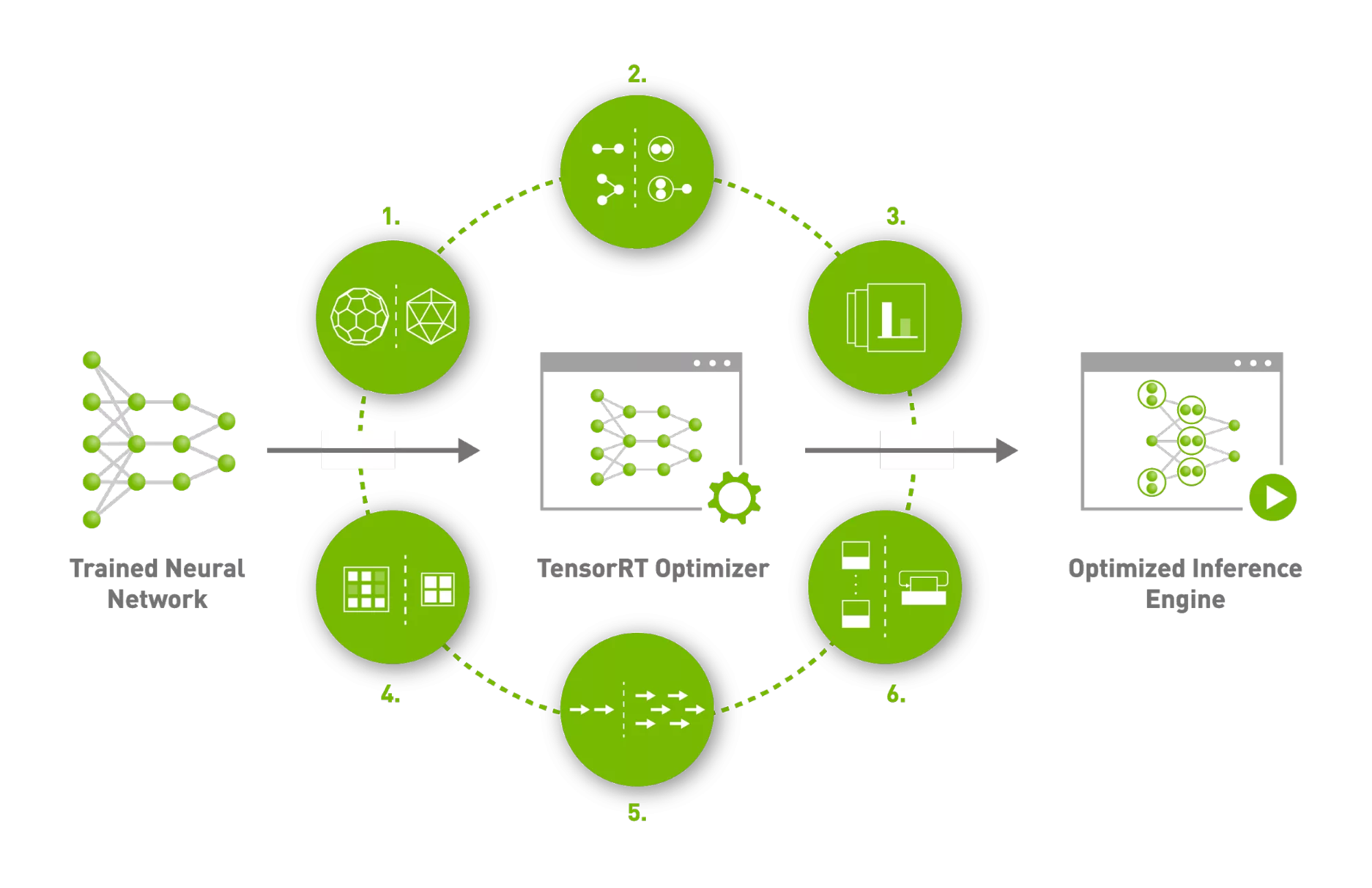

Optimizasyon süreci, TensorRT’nin eşsiz özelliklerinden biridir. Bu süreç, kullanıcıların eğittikleri modellerin gereksiz parametrelerini kaldırarak o modelin verimliliğini artırmayı kapsamaktadır. Kullanıcılar, TensorRT ile model eğitimi sırasında elde ettikleri çıktıları gizleyebilir, bileşenleri birleştirebilir veya değişen veri türlerini tanıtabilirler. Bu benzeri optimizasyon teknikleri, sonuçta hem daha hızlı bir sonuç almakta hem de daha az kaynak tüketmektedir. TensorRT ayrıca kullanıcılara, performansı analiz etme ve çeşitli model yapılandırmalarının etkisini görselleştirme imkanı sunar. Böylece, geliştiriciler kendi iş akışlarına en uygun tasarımı daha kolay bir şekilde belirleyebilir.

Sıkça Sorulan Sorular

NVIDIA TensorRT nedir ve yapay zeka hızlandırmada nasıl bir rol oynar?

NVIDIA TensorRT, yapay zeka modellerinin daha hızlı ve verimli bir şekilde çalışmasını sağlayan bir optimizasyon ve çıkarım kütüphanesidir. GeForce RTX GPU’larında kullanılabilen TensorRT, özellikle DirectML’e kıyasla %200’e kadar performans artırımı sunarak, yapay zeka uygulamalarını hızlandırmak için tasarlanmıştır.

GeForce RTX GPU’larındaki TensorRT’nin avantajları nelerdir?

GeForce RTX GPU’larında kullanılan NVIDIA TensorRT, yapay zeka hızlandırmada yüksek performans sunar. TensorRT ile kullanıcılar, DirectML’e göre %50’den fazla daha hızlı performans elde edebilirler. Ayrıca, TensorRT’nin sağladığı optimize edilmiş çıkarım sayesinde, uygulamalar daha hızlı ve verimli bir şekilde çalışır.

Windows ML ile NVIDIA TensorRT nasıl entegre çalışmaktadır?

Windows ML, NVIDIA TensorRT’yi otomatik olarak kullanarak, GeForce RTX GPU’larında yüksek performanslı yapay zeka uygulamaları geliştirmek için optimize edilmiştir. Bu entegrasyon sayesinde, Windows ML her bir yapay zeka özelliği için doğru donanımı seçip, gerekli yürütme sağlayıcısını otomatik olarak indirerek geliştirme sürecini kolaylaştırır.

TensorRT ile DirectML arasında ne gibi performans farkları vardır?

NVIDIA TensorRT, PC’lerdeki yapay zeka iş yükleri için DirectML’e göre %50’den fazla daha hızlı performans sunar. Bu, TensorRT’nin optimize edilmiş kütüphane dosyaları ve hızlı çalışma süreleri sayesinde mümkündür, bu da kullanıcıların daha iyi bir performans ve kullanıcı deneyimi elde etmesini sağlar.

ONNX Runtime ve TensorRT’nin ilişkisi nedir?

ONNX Runtime, NVIDIA TensorRT ile sorunsuz bir şekilde entegre edilmiştir. TensorRT, Windows ML üzerinden kullanılan ONNX modelleri ile çalışarak, yapay zeka çıkarımında daha optimize bir performans sunar. Bu ilişki, geliştiricilerin çeşitli yapay zeka modellerini etkin bir şekilde kullanmalarını sağlar.

NVIDIA TensorRT’nin geliştiriciler için sağladığı faydalar nelerdir?

NVIDIA TensorRT, geliştiricilere sağladığı optimize edilmiş çalışma süreleri ve donanım uyumluluğu ile önemli avantajlar sunar. Geliştiriciler, TensorRT sayesinde daha hızlı dağıtımlar, daha düşük performans kayıpları ve çoklu donanım desteği ile çalışarak, uygulamalarını daha verimli hale getirebilirler.

NVIDIA TensorRT’nin sağladığı en güncel performans iyileştirmeleri nelerdir?

NVIDIA TensorRT, sürekli olarak güncellenen performans optimizasyonları ile birlikte gelir. Örneğin, RTX için daha küçük kütüphane dosyası boyutları ve zamanında optimizasyonlar gibi yenilikler, yapay zeka uygulamalarının performansını ve verimliliğini artırmaktadır.

TensorRT kullanarak ComfyUI veya DaVinci Resolve’de nasıl performans artışı sağlarım?

TensorRT kullanarak ComfyUI gibi uygulamalarda %200’e kadar performans artışı sağlanabilirken, DaVinci Resolve gibi profesyonel yazılımlarda da %60’a varan iyileştirmeler elde etmek mümkündür. Bu artışlar, NVIDIA’nın optimize edilmiş yapay zeka hızlandırma teknolojisi sayesinde mümkün olmaktadır.

NVIDIA TensorRT, yapay zeka uygulamalarınızın performansını önemli ölçüde artırma potansiyeline sahip bir derin öğrenme optimizasyon motorudur. Bu teknoloji, AI modellerinizi hızlandırarak, karmaşık hesaplamaları daha hızlı ve verimli bir şekilde gerçekleştirmenizi sağlar. TensorRT sayesinde, inferans sürelerini azaltabilir ve gerçek zamanlı uygulamalarınızda muazzam bir hız kazancı elde edebilirsiniz. Hem grafik hem de hesaplama gücü açısından en iyi sonuçları almak istiyorsanız, TensorRT entegrasyonu ile AI performansınızı iki katına çıkarmanız mümkün!

Artık yapay zeka projelerinizde NVIDIA TensorRT kullanarak rekabet avantajınızı artırma zamanı! Modellerinizi optimize edin ve önceden düşünülmeyen hızda sonuçlar elde edin. Unutmayın, daha hızlı ve etkili bir AI performansı, işinizin başarısında büyük rol oynar. Hedeflerinize ulaşmak ve sektörünüzde öne çıkmak için gelin şimdi NVIDIA TensorRT ile AI çözümlerinizi güçlendirin. Geriye dönüp bakmak istemiyorsanız, harekete geçin ve bu devrim niteliğindeki teknolojiyi deneyimleyin!